Attention Is All You Need

1. 预备知识

1.1 Encoder/Decoder

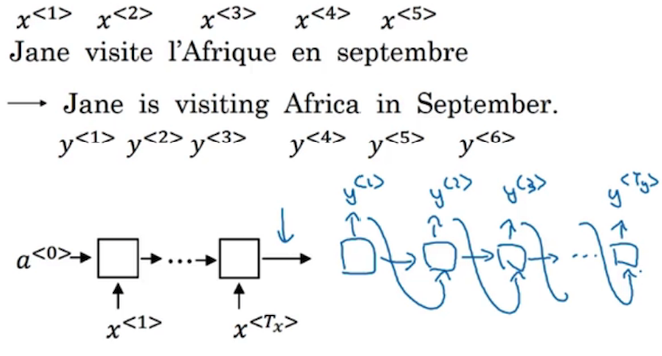

序列模型由Encoder与Decoder两部分构成,简单来说,Encoder对input进行编码,而Decoder对编码结果进行解码,解码的结果就是整个序列模型的输出。借用Andrew Ng课件中的截图来进行说明:

Encoder的每一个单元会根据前一个hidden state以及当前的input来计算当前的hidden state,并将其传到下一个单元中去。而Decoder对于传入的单元进行解码,来找到最合适的一个输出。注意每个Decoder单元只会输出一个output symbol。